随着电脑游戏和专业图形处理需求的不断提升,显卡在PC组件中的地位愈发重要。作为保障显卡稳定运行的重要配件,显卡原装支架的作用不容小觑。在购买显卡原装支...

2025-05-23 3 显卡

随着人工智能技术的飞速发展,大模型的训练和应用变得越来越普遍。运行这些模型需要强大的计算能力,而显卡(GPU)在这一过程中扮演了至关重要的角色。本文将为您详细讲解显卡运行大模型的原理,以及使用显卡运行模型的具体步骤。

在深度学习领域,显卡(尤其是NVIDIA的GPU)因其并行计算能力强大,已成为处理复杂模型的首选硬件。显卡运行大模型的基本原理是利用其内部的众多核心同时进行计算,这可以大幅度提升运算速度,并处理海量数据。

硬件选择

在开始之前,确保您拥有一张性能足够的显卡。对于大模型而言,GTX10系列或以上的NVIDIA显卡是比较理想的选择。

软件环境搭建

您需要安装适当的驱动程序以及支持深度学习的软件环境,如CUDA(ComputeUnifiedDeviceArchitecture)和cuDNN。Python、TensorFlow、PyTorch等编程语言和框架也是必须的。

数据准备

准备好需要处理的数据,并进行必要的预处理,包括数据清洗、格式转换等。

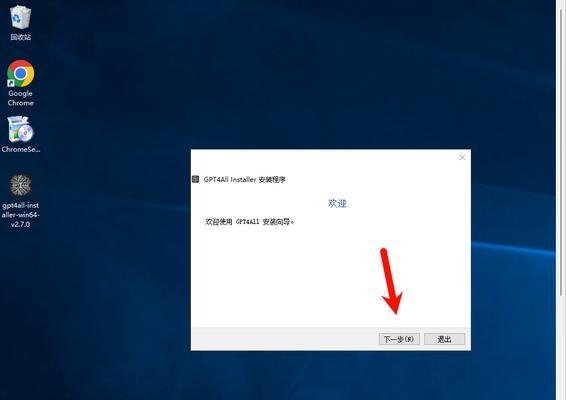

步骤一:安装显卡驱动

确保显卡驱动是最新的,这样才能充分利用硬件性能。访问NVIDIA官方网站下载并安装相应的驱动程序。

步骤二:安装CUDA和cuDNN

CUDA是NVIDIA提供的GPU计算平台,cuDNN是其深度学习加速库。它们能帮助您的显卡更好地运行大模型。

前往CUDA官网下载与显卡相匹配的CUDA版本。

根据CUDA版本下载cuDNN,并按照官方指南进行安装。

步骤三:创建虚拟环境

为了保证运行环境的干净整洁,建议使用如Anaconda这样的工具创建一个新的虚拟环境。

```bash

condacreate-ngpu_envpython=3.8

```

激活并进入虚拟环境:

```bash

condaactivategpu_env

```

步骤四:安装深度学习框架

在虚拟环境中安装TensorFlow或PyTorch等深度学习框架。以TensorFlow为例:

```bash

pipinstalltensorflow-gpu

```

步骤五:模型准备

准备好您要运行的模型代码。如果是从网络上下载的模型,请确保其兼容GPU运算。

步骤六:编写训练代码

编写训练大模型的代码,需要包括数据加载、模型构建、训练循环等部分。具体代码视模型和任务而定。

步骤七:执行训练

在命令行中运行您的训练代码。确保使用`python`命令来启动Python解释器。

```bash

pythontrain.py

```

步骤八:监控和调试

利用NVIDIA提供的工具,如NVIDIA-SMI,监控显卡的运行状态,确保模型训练过程中显卡运行平稳。

显卡驱动安装失败:尝试卸载旧驱动后再重新安装。

CUDA和cuDNN版本不兼容:下载与您的GPU和CUDA版本相匹配的cuDNN。

模型运行慢:确认模型是否真正利用到了GPU资源。可以在Python代码中使用`tf.test.is_gpu_available()`或类似函数检查。

优化显存使用:合理设计模型结构,避免不必要的资源浪费。

使用混合精度训练:混合使用float16和float32数据类型,以提升训练速度和效率。

定期清理无用文件:释放磁盘空间,提升整体系统性能。

通过以上详细的步骤和技巧,您现在应该能够利用显卡运行大模型了。当然,每一步都可能遇到具体问题,需要您根据实际情况进行调整和优化。

综上所述,使用显卡运行大模型需要一系列周密的准备和执行步骤,但只要按照正确的方法操作,您就可以充分发挥显卡的潜力,高效地进行模型训练与研究。

标签: 显卡

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

相关文章

随着电脑游戏和专业图形处理需求的不断提升,显卡在PC组件中的地位愈发重要。作为保障显卡稳定运行的重要配件,显卡原装支架的作用不容小觑。在购买显卡原装支...

2025-05-23 3 显卡

显卡灯光如何编辑?有哪些自定义选项?随着个性化和审美多样化的需求日益增长,显卡灯光效果的编辑和自定义成为了众多电脑爱好者关注的焦点。不仅硬件制造商...

2025-05-22 6 显卡

显卡支架对于保障显卡稳定性和延长其寿命有着至关重要的作用。本文将为您详细阐述显卡支架的安装和组装步骤,确保您能顺利地为自己的电脑显卡安装上一个理想的支...

2025-05-21 9 显卡

在当今快节奏的电子竞技领域,拥有一块能提供高帧率的显卡是至关重要的。但对于广大游戏玩家而言,面对形形色色的显卡选择,怎样才能找到最适合自己的呢?特别是...

2025-05-21 5 显卡

显卡作为计算机中负责处理图像数据的重要部件,其运行速度和稳定性对于电脑性能有着至关重要的影响。随着游戏和图形处理需求的不断提高,显卡的发热量也越来越大...

2025-05-20 10 显卡

在现代计算机系统中,显卡是提升图形处理能力的核心部件。它负责将计算机生成的数据转化为可见的图像,展现给用户。安装显卡可能对一些初学者来说是个技术活,但...

2025-05-19 9 显卡